Inhaltsverzeichnis

Die Gütekriterien zeigen, ob deine Forschung wissenschaftlichen Standards entspricht. Betreuende erwarten, dass du im Methodikteil konkret beschreibst, wie du Qualität sichergestellt hast. Hier erfährst du, welche Kriterien es gibt, wie du sie prüfst und wie du sie im Ergebnis- und Methodikteil korrekt berichtest.

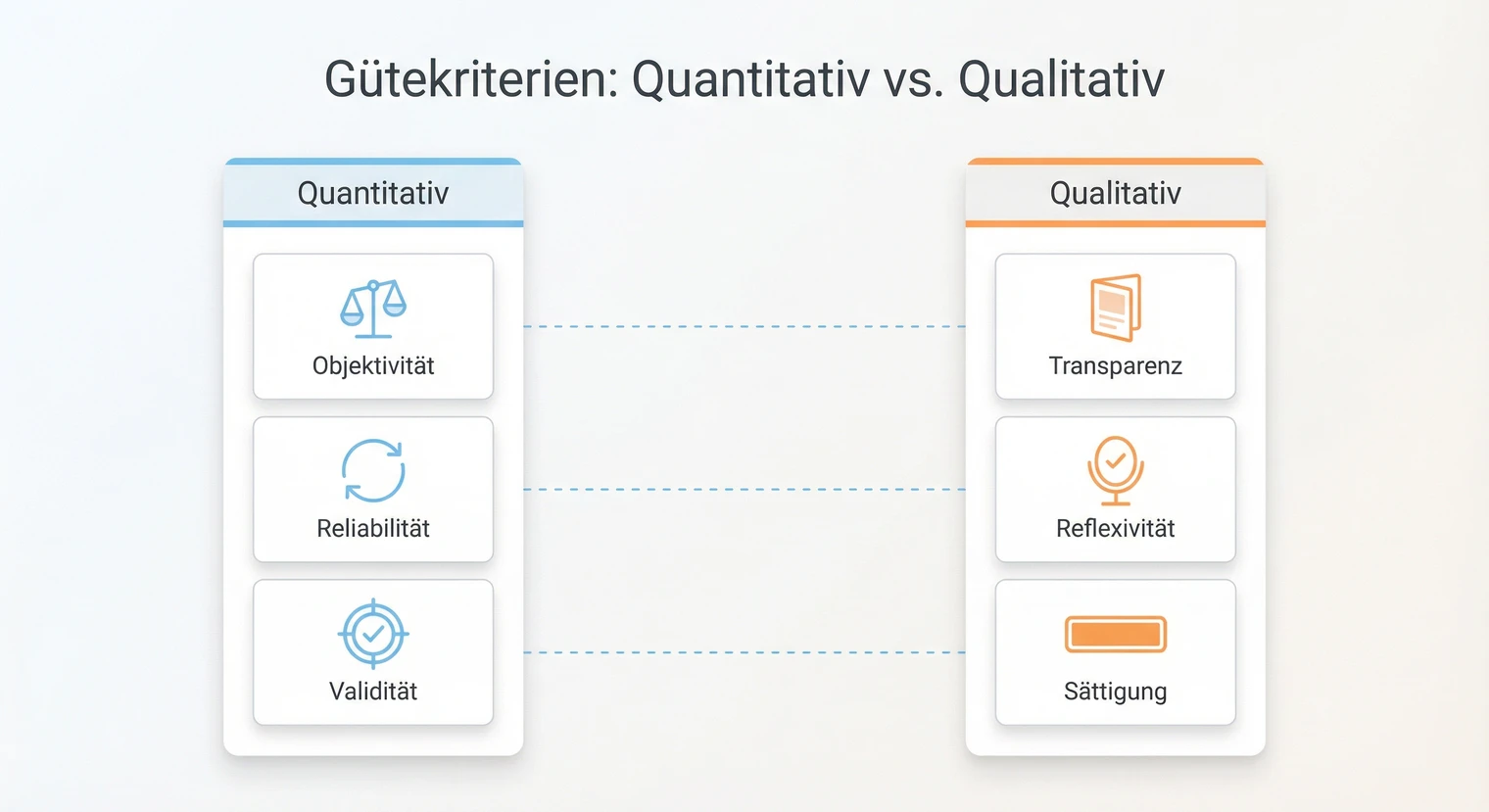

Gütekriterien: Quantitative Forschung prüft Objektivität, Reliabilität (z. B. Cronbachs Alpha, oft ab etwa .70 als Faustregel, abhängig von Skalenlänge und Fachvorgaben) und Validität (Inhalts-, Konstrukt-, Kriteriumsvalidität). Qualitative Forschung nutzt eigene Kriterien: Transparenz, Reflexivität, theoretische Sättigung. Je nach Design sind unterschiedliche Checks realistisch.

Die Angaben in diesem Artikel sind Orientierungswerte. Welche Gütekriterien dein Lehrstuhl erwartet und wie detailliert du sie dokumentieren sollst, kann je nach Fachkultur und Studiengang variieren. Prüfe die Richtlinien deines Studiengangs und sprich im Zweifel mit deiner Betreuung.

Schnellcheck: Was musst du berichten?

Je nach Forschungsansatz sind unterschiedliche Gütekriterien relevant. Diese Übersicht zeigt dir auf einen Blick, was du im Methodikteil und Ergebnisteil typischerweise adressieren solltest.

Objektivität: Standardisierte Durchführung dokumentieren (identische Instruktionen, gleiche Bedingungen)

Reliabilität: Cronbachs Alpha (α) oder McDonald's Omega (ω) für jede Skala berichten, inkl. Itemanzahl

Validität: Begründung der Skalenwahl (etabliert vs. selbst entwickelt), mind. ein Validitätsargument (Inhalts- oder Konstruktvalidität)

Externe Validität: Stichprobe und Setting als Grenzen der Generalisierbarkeit benennen

Analyse-Entscheidungen: Umgang mit Missing Data, Ausreißern, Annahmenprüfung dokumentieren

Transparenz: Sampling-Kriterien, Leitfaden, Transkriptionsregeln, Codierleitfaden mit Ankerbeispielen offenlegen

Reflexivität: Eigene Rolle und Vorannahmen reflektieren (Methodikteil oder Diskussion)

Sättigung: Begründung, ab wann keine neuen Kategorien mehr auftraten

Intercoderreliabilität: Mindestens Teilmaterial doppelt codieren oder begründen, warum nicht möglich

Optional: Peer-Debriefing, kommunikative Validierung, Triangulation

Entscheidungshilfe nach Forschungsdesign

Nicht jedes Forschungsdesign erfordert dieselben Güteprüfungen. Dieser Entscheidungsbaum hilft dir, die für dein Design realistischen Checks zu identifizieren.

Fokus interne Validität: Randomisierung dokumentieren, Störvariablen kontrollieren, Manipulation Check berichten. Reliabilität der abhängigen Variable prüfen (α). Externe Validität als Limitation diskutieren (Laborsetting vs. Feld).

Berichten: Gruppenzuweisung, Manipulation Check, α der Outcome-Skala, Effektstärke.

Fokus Reliabilität und Konstruktvalidität: Für jede Skala Cronbachs Alpha berichten. Bei selbst entwickelten Items: Faktorenanalyse oder Begründung der Itemauswahl. Stichprobe als Grenze der Generalisierbarkeit benennen.

Berichten: α pro Skala, Itemanzahl, Skalenquelle, ggf. KMO/Bartlett bei Faktorenanalyse.

Fokus Transparenz und Sättigung: Sampling-Logik, Leitfaden und Codierleitfaden dokumentieren. Begründen, ab welchem Interview Sättigung erreicht wurde. Intercoderreliabilität anstreben oder Begründung, warum nicht möglich.

Berichten: Sampling-Kriterien, Interviewanzahl, Sättigungsargument, ggf. Cohens Kappa.

Fokus Nachvollziehbarkeit: Korpusauswahl begründen, Kategoriensystem mit Ankerbeispielen und Codierregeln dokumentieren. Bei quantifizierender Inhaltsanalyse: Intercoderreliabilität prüfen (Cohens Kappa, häufig werden Werte ab etwa .60 als moderate Übereinstimmung eingestuft).

Berichten: Ein-/Ausschlusskriterien, Codierleitfaden im Anhang, ggf. Kappa-Wert.

Die drei klassischen Gütekriterien

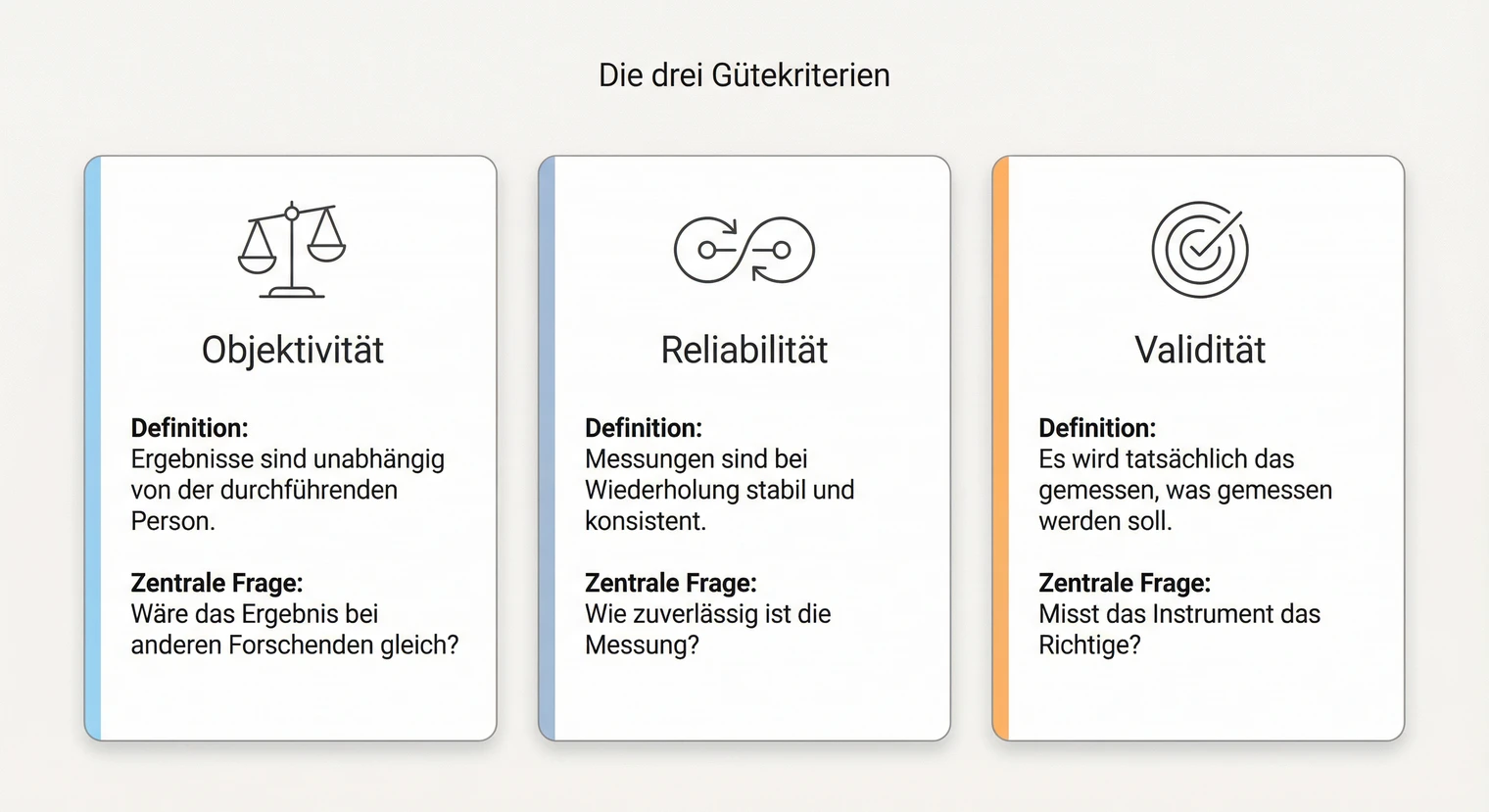

Objektivität, Reliabilität und Validität bilden das Fundament quantitativer Forschung. Sie bauen hierarchisch aufeinander auf: Ohne Objektivität ist keine Reliabilität möglich, ohne Reliabilität keine Validität. Das bedeutet nicht, dass alle drei immer perfekt erfüllt sein müssen, aber du solltest reflektieren, wo deine Studie steht.

Die drei Kriterien stellen unterschiedliche Fragen an deine Forschung. Objektivität fragt: Wäre das Ergebnis bei einem anderen Forschenden gleich? Reliabilität fragt: Wäre das Ergebnis bei einer Wiederholung gleich? Validität fragt: Ist das Ergebnis überhaupt das richtige? Diese Fragen helfen dir, systematisch über die Qualität deiner Methode nachzudenken.

Objektivität: Unabhängigkeit vom Forschenden

Objektivität bedeutet, dass die Ergebnisse unabhängig von der Person sind, die die Forschung durchführt. Ein anderer Forschender sollte mit denselben Daten und derselben Methode zu denselben Ergebnissen kommen. Das Kriterium unterteilt sich in drei Bereiche.

Die Erhebung sollte standardisiert ablaufen. Bei Umfragen heißt das: Alle Teilnehmenden erhalten dieselben Fragen in derselben Reihenfolge. Bei Interviews: Ein Leitfaden gibt die Struktur vor.

Prüffrage: Würde ein anderer Forschender die Erhebung genauso durchführen können?

Die Auswertung sollte nach klaren Regeln erfolgen. Quantitative Analysen sind stärker regelgeleitet, aber auch hier bleiben Entscheidungen: Umgang mit Missing Data, Ausreißerbehandlung, Modellwahl, Signifikanzniveau. Diese Entscheidungen müssen dokumentiert werden. Bei qualitativen Daten hilft ein Codierleitfaden mit Ankerbeispielen.

Prüffrage: Würde ein anderer Forschender mit denselben Daten und denselben dokumentierten Regeln zum selben Ergebnis kommen?

Die Schlussfolgerungen sollten aus den Daten ableitbar sein, nicht aus persönlichen Überzeugungen. Das ist der schwierigste Bereich, weil Interpretation immer Spielräume lässt.

Prüffrage: Würde ein anderer Forschender aus denselben Ergebnissen dieselben Schlüsse ziehen?

Vollständige Objektivität ist ein Ideal, das in der Praxis nie ganz erreicht wird. Dokumentiere deshalb transparent, wie du vorgegangen bist. So können andere dein Vorgehen nachvollziehen und einschätzen.

Reliabilität: Zuverlässigkeit der Messung

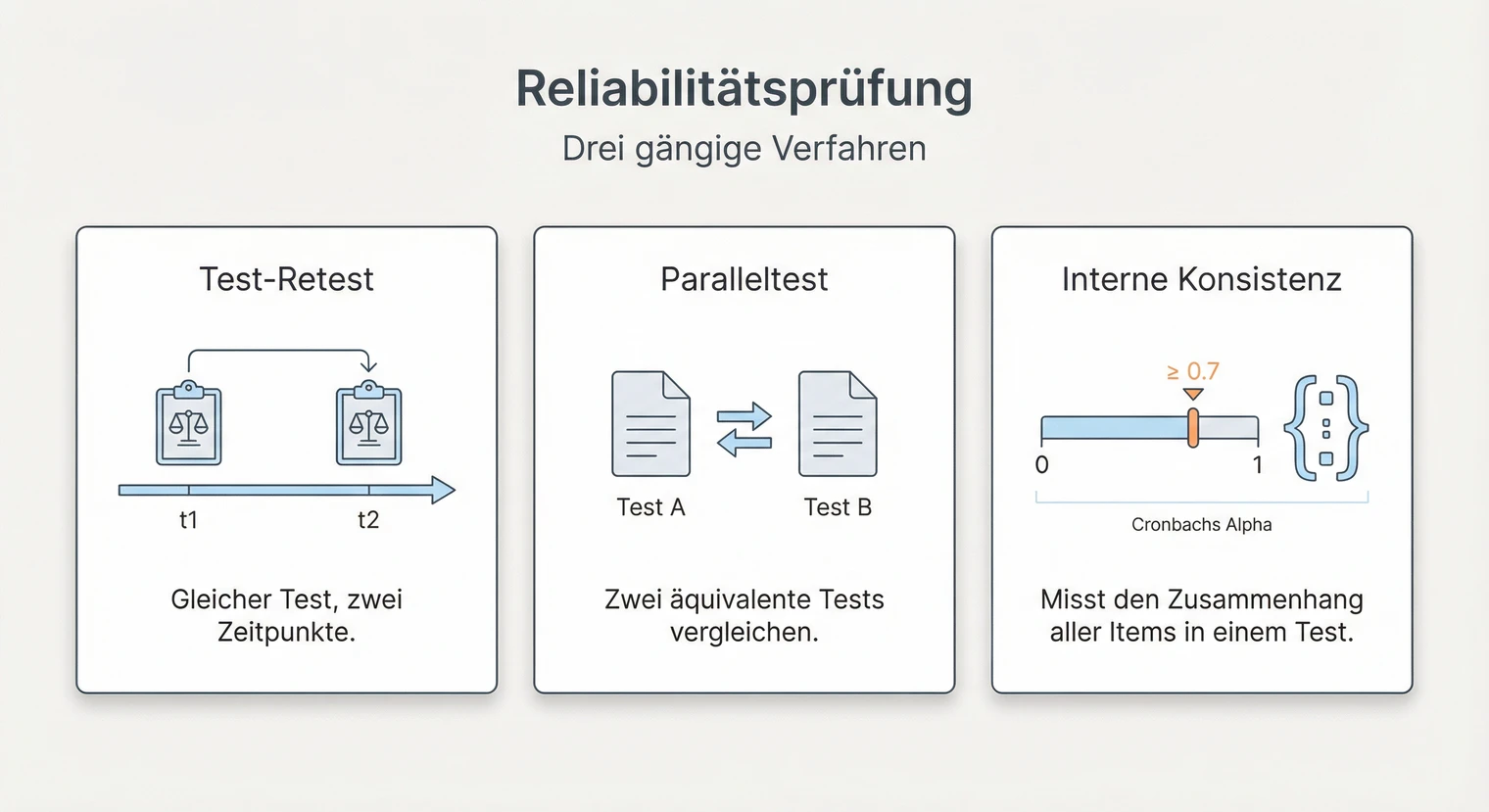

Reliabilität beschreibt, wie zuverlässig und konsistent dein Messinstrument ist. Eine reliable Messung liefert bei Wiederholung unter gleichen Bedingungen gleiche Ergebnisse. Das Konzept lässt sich auf verschiedene Arten prüfen.

Dieselbe Messung wird zu zwei Zeitpunkten durchgeführt. Die Ergebnisse werden korreliert. Hohe Korrelation zeigt hohe Stabilität über Zeit. Problem: Bei lernbaren Inhalten oder instabilen Konstrukten (z. B. Stimmung) ist das Verfahren ungeeignet.

In der Masterarbeit: Selten praktikabel, weil zwei Erhebungszeitpunkte nötig sind.

Zwei äquivalente Versionen eines Tests werden durchgeführt. Die Ergebnisse werden korreliert. Problem: Zwei wirklich parallele Tests zu konstruieren ist aufwändig.

In der Masterarbeit: In der Regel nicht praktikabel.

Die gebräuchlichste Methode in Masterarbeiten. Cronbachs Alpha misst, wie stark die Items einer Skala zusammenhängen. Werte zwischen 0 und 1 sind möglich. Typische Richtwerte: ab etwa .70 wird häufig als akzeptabel eingestuft, ab .80 als gut, über .90 als möglicherweise redundant. Diese Schwellen sind kontextabhängig: Bei kurzen Skalen oder explorativen Studien können auch niedrigere Werte vertretbar sein.

So berechnest du es: In SPSS unter „Analysieren → Skala → Reliabilitätsanalyse“. In R mit der Funktion alpha() aus dem psych-Paket. In jamovi unter „Factor → Reliability Analysis“.

Grenzen von Cronbachs Alpha: Der Wert steigt mit der Itemanzahl, sodass lange Skalen leichter hohe Werte erreichen. Alpha setzt tau-äquivalente Items voraus (gleiche Faktorladungen), was oft nicht erfüllt ist. Option: McDonald's Omega (ω) ist robuster und wird zunehmend empfohlen. Viele Tools (jamovi, R psych-Paket) berechnen beide Werte gleichzeitig. Wenn dein Tool es bietet, kannst du beide berichten.

Hohe Reliabilität garantiert keine Validität. Eine Waage kann zuverlässig immer dasselbe Gewicht anzeigen, aber systematisch 2 kg zu viel. Die Messung wäre reliabel, aber nicht valide. Reliabilität ist notwendig, aber nicht hinreichend für Validität.

Bei qualitativer Forschung wird statt Cronbachs Alpha oft die Intercoderreliabilität geprüft. Zwei oder mehr Personen codieren dasselbe Material unabhängig voneinander. Die Übereinstimmung wird mit Cohens Kappa oder Krippendorffs Alpha gemessen. Als Orientierung: Werte ab etwa 0,6 werden häufig als moderate, ab 0,8 als gute Übereinstimmung interpretiert. Die konkreten Anforderungen können je nach Fach und Komplexität des Kategoriensystems variieren.

Validität: Gültigkeit der Ergebnisse

Validität ist das anspruchsvollste Gütekriterium. Es fragt, ob du tatsächlich das misst, was du messen willst. Ein Fragebogen zur Arbeitszufriedenheit sollte Arbeitszufriedenheit erfassen, nicht etwa allgemeines Wohlbefinden oder soziale Erwünschtheit.

Decken die Items das Konstrukt inhaltlich ab? Eine Skala zur Arbeitszufriedenheit sollte verschiedene Aspekte erfassen: Aufgaben, Kollegen, Führung, Bezahlung. Wenn nur ein Aspekt abgefragt wird, fehlt Inhaltsvalidität.

So prüfst du es: Expertenurteil oder Literaturabgleich. Dokumentiere, wie du die Items ausgewählt hast und welche Dimensionen sie abdecken sollen.

Misst das Instrument das theoretische Konstrukt? Zwei Aspekte sind relevant: Konvergente Validität (hohe Korrelation mit ähnlichen Konstrukten) und diskriminante Validität (niedrige Korrelation mit unterschiedlichen Konstrukten).

So prüfst du es: Faktorenanalyse (laden Items auf den erwarteten Faktoren?), Korrelationen mit anderen Skalen. In Masterarbeiten oft begrenzt möglich, weil dafür zusätzliche Konstrukte erhoben werden müssten.

Korreliert das Messergebnis mit einem externen Kriterium? Bei einem Test zur Studieneignung wäre das Außenkriterium der spätere Studienerfolg. Man unterscheidet Vorhersagevalidität (Kriterium liegt in der Zukunft) und Übereinstimmungsvalidität (Kriterium liegt zum selben Zeitpunkt vor).

So prüfst du es: Korrelation mit dem Außenkriterium berechnen. In Masterarbeiten oft nicht möglich, weil das Außenkriterium nicht verfügbar ist.

Neben diesen Aspekten der Messvalidität gibt es interne und externe Validität, die sich auf das Studiendesign beziehen. Interne Validität fragt, ob Störvariablen ausgeschlossen wurden. Externe Validität fragt, ob die Ergebnisse auf andere Kontexte übertragbar sind. Bei der Wahl der Forschungsmethode spielen beide eine Rolle.

Validitätsbedrohungen erkennen und begrenzen

Validitätsbedrohungen sind Faktoren, die deine Ergebnisse verzerren können. Wenn du sie kennst, kannst du Gegenmaßnahmen ergreifen oder sie zumindest als Limitation benennen. Hier die häufigsten Bedrohungen mit realistischen Gegenmaßnahmen für Masterarbeiten.

Selektion: Gruppen unterscheiden sich schon vor der Intervention. Gegenmaßnahme: Randomisierung oder Matching; Baseline-Unterschiede prüfen und berichten.

History/Maturation: Äußere Ereignisse oder natürliche Entwicklung überlagern den Effekt. Gegenmaßnahme: Kontrollgruppe ohne Intervention; kurzer Erhebungszeitraum.

Instrumentation: Das Messinstrument verändert sich oder wird unterschiedlich angewendet. Gegenmaßnahme: Standardisierte Instruktionen; Pretest des Fragebogens.

Demand/Soziale Erwünschtheit: Teilnehmende antworten so, wie sie glauben, dass es erwartet wird. Gegenmaßnahme: Anonymität zusichern; neutrale Frageformulierung; Attention Checks einbauen.

Convenience-Sample: Stichprobe ist nicht repräsentativ (z. B. nur Studierende). Gegenmaßnahme: Stichprobe beschreiben; Generalisierbarkeit als Limitation benennen.

Setting: Laborbedingungen entsprechen nicht der Realität. Gegenmaßnahme: Ökologische Validität diskutieren; ggf. Feldstudie statt Laborstudie.

Zeitbezug: Ergebnisse gelten nur für den Erhebungszeitraum (z. B. während einer Krise). Gegenmaßnahme: Erhebungszeitraum dokumentieren; Zeitbezug als Limitation benennen.

Du musst nicht alle Bedrohungen eliminieren, das ist in einer Masterarbeit unrealistisch. Entscheidend ist, dass du die relevanten Bedrohungen für dein Design kennst, Gegenmaßnahmen ergreifst, wo möglich, und verbleibende Einschränkungen in der Diskussion benennst.

Nebengütekriterien im Überblick

Neben den drei Hauptkriterien gibt es Nebengütekriterien, die vor allem bei Testentwicklung und bei der Arbeit mit vulnerablen Gruppen relevant werden. In den meisten Masterarbeiten reicht es, die Hauptkriterien zu adressieren. Wenn du jedoch ein eigenes Instrument entwickelst oder besondere Zielgruppen befragst, solltest du diese Kriterien kennen.

- Ökonomie: Ist der Aufwand für Durchführung und Auswertung vertretbar? Ein Fragebogen mit 200 Items ist zwar vielleicht reliabler, aber für Teilnehmende und Auswertung unpraktikabel. In Masterarbeiten relevant, wenn du die Länge deines Instruments begründen musst.

- Zumutbarkeit: Ist die Teilnahme für die Befragten zumutbar? Besonders relevant bei sensiblen Themen oder langen Erhebungen. In Masterarbeiten: Begründe, warum du bestimmte Fragen stellst, und halte die Erhebung so kurz wie nötig.

- Fairness: Werden bestimmte Gruppen durch das Instrument benachteiligt? Zum Beispiel durch sprachliche Komplexität oder kulturelle Vorannahmen. In Masterarbeiten: Prüfe, ob dein Instrument für deine Zielgruppe verständlich ist (Pretest).

- Nützlichkeit: Liefert die Messung praktisch verwertbare Ergebnisse? In Masterarbeiten meist gegeben, wenn du eine klare Forschungsfrage hast.

Methodikteil (Instrument): Begründe die Länge deines Fragebogens oder Leitfadens. Beispiel: „Der Fragebogen wurde auf 25 Items begrenzt, um eine Bearbeitungszeit von etwa 10 Minuten zu gewährleisten (Ökonomie).“

Ethikteil oder Methodikteil: Bei sensiblen Themen oder vulnerablen Gruppen: „Die Fragen wurden vorab mit Betroffenen auf Verständlichkeit und Zumutbarkeit geprüft (Pretest).“

Diskussion (Limitationen): „Die Stichprobe umfasste ausschließlich deutschsprachige Teilnehmende; die Generalisierbarkeit auf andere Sprachgruppen ist eingeschränkt (Fairness).“

Gütekriterien qualitativer Forschung

Für qualitative Forschung werden die klassischen Gütekriterien oft als unpassend kritisiert. Qualitative Forschung zielt nicht auf Wiederholbarkeit im engen Sinne, sondern auf Verstehen und Nachvollziehbarkeit. Verschiedene Autoren schlagen alternative Kriterien vor. Ein verbreitetes Framework ist „Trustworthiness“ nach Lincoln und Guba mit den Dimensionen Glaubwürdigkeit, Übertragbarkeit, Zuverlässigkeit und Bestätigbarkeit. Wenn dein Lehrstuhl diese Terminologie nutzt, kannst du die folgenden Kriterien entsprechend zuordnen.

Dokumentiere dein Vorgehen so, dass andere es nachvollziehen können. Wie hast du dein Sample ausgewählt? Wie bist du beim Codieren vorgegangen? Welche Entscheidungen hast du getroffen und warum?

Konkret: Sampling-Kriterien offenlegen, Codierleitfaden mit Ankerbeispielen beifügen, Auswertungsschritte beschreiben.

Reflektiere deine eigene Rolle im Forschungsprozess. Welche Vorannahmen bringst du mit? Wie könnten diese die Datenerhebung und Interpretation beeinflusst haben?

Konkret: Im Methodikteil oder in der Diskussion kurz reflektieren. Manche Forschende führen ein Forschungstagebuch.

Zeige, dass du genug Material erhoben hast. Neue Fälle liefern keine wesentlich neuen Erkenntnisse mehr. Das Kategoriensystem ist stabil.

Konkret: Dokumentiere, ab wann keine neuen Kategorien mehr auftraten. Begründe, warum du bei dieser Fallzahl aufgehört hast.

Weitere Strategien zur Qualitätssicherung in qualitativer Forschung sind Triangulation (mehrere Datenquellen oder Methoden), kommunikative Validierung (Ergebnisse mit Befragten rückkoppeln) und Peer-Debriefing (mit Kolleginnen über Interpretation diskutieren). Nicht alle müssen in einer Masterarbeit umgesetzt werden, aber es ist hilfreich, die Optionen zu kennen.

So berichtest du Gütekriterien (mit Beispielen)

Betreuende erwarten, dass du im Methodikteil darlegst, wie du die Gütekriterien adressiert hast, und im Ergebnisteil die konkreten Werte berichtest. Das zeigt methodische Reflexion und macht deine Arbeit glaubwürdiger. Hier konkrete Vorlagen und Beispiele.

„Zur Sicherstellung der Objektivität wurde der Fragebogen standardisiert durchgeführt; alle Teilnehmenden erhielten identische Instruktionen über die Online-Plattform [Name]. Die interne Konsistenz der verwendeten Skalen wurde mittels Cronbachs Alpha geprüft (siehe Ergebnisteil). Die Inhaltsvalidität wurde durch Rückgriff auf etablierte Skalen aus [Quelle] gesichert. Die Konstruktvalidität konnte im Rahmen dieser Arbeit nicht umfassend geprüft werden; mögliche Einschränkungen werden in der Diskussion reflektiert. Missing Data wurde mittels [listenweisem Ausschluss / Imputation] behandelt; [n] Fälle wurden aufgrund unvollständiger Daten ausgeschlossen."

So könnte ein Absatz zur Reliabilität in deinem Ergebnisteil aussehen:

„Tabelle 1 zeigt die deskriptiven Statistiken und Reliabilitätswerte der verwendeten Skalen. Die Skala Arbeitszufriedenheit (5 Items; Beispielitem: ‚Insgesamt bin ich mit meiner Arbeit zufrieden') wies eine interne Konsistenz von α = .82 auf, was nach gängigen Konventionen als gut gilt (Nunnally, 1978). Die Skala Arbeitsbelastung (4 Items) erreichte α = .74. Für die Skala Work-Life-Balance (3 Items) ergab sich α = .68; der Wert liegt knapp unter dem häufig genannten Richtwert von .70, was durch die geringe Itemanzahl erklärbar ist. Die Skala wurde aufgrund ihrer theoretischen Relevanz beibehalten."

Wichtig: Nenne für jede Skala: Name, Itemanzahl, ggf. Beispielitem, α-Wert, Interpretation. Bei Werten unter .70 begründe, warum du die Skala trotzdem verwendest.

„Zur Qualitätssicherung wurde das Vorgehen transparent dokumentiert. Der Interviewleitfaden (Anhang A), die Transkriptionsregeln (Anhang B) und der Codierleitfaden mit Ankerbeispielen (Anhang C) sind der Arbeit beigefügt. Die Kategorienbildung erfolgte [deduktiv aus der Theorie / induktiv am Material / in einer Kombination beider Ansätze]. Ab Interview 10 lieferten neue Gespräche keine wesentlich neuen Kategorien mehr, sodass von theoretischer Sättigung ausgegangen werden kann. Zur Überprüfung der Auswertungsobjektivität wurden 20 % des Materials (n = 3 Interviews) von einer zweiten Person unabhängig codiert; die Übereinstimmung lag bei κ = .72 (Cohens Kappa), was als substanziell gilt."

So könnte eine Sättigungsbegründung im Methodikteil aussehen:

„Die Datenerhebung wurde nach 12 Interviews beendet. Ab Interview 9 traten keine neuen Hauptkategorien mehr auf. Die letzten drei Interviews dienten der Konsolidierung und bestätigten das Kategoriensystem. Die Entwicklung des Kategoriensystems wurde in einem Auswertungsprotokoll dokumentiert (Forschungstagebuch), das den Codierprozess nachvollziehbar macht. Alle Entscheidungen zur Kategorienbildung und -zusammenführung wurden mit Datum und Begründung festgehalten."

Tipp: Falls keine zweite Person für Intercoderreliabilität verfügbar war, beschreibe alternativ dein Vorgehen zur Konsistenzsicherung (z. B. zweimaliges Durchgehen des Materials, Peer-Debriefing zu Kategorien).

Passe die Formulierungen an dein konkretes Vorgehen an. Die Vorlagen sind Ausgangspunkte, keine Copy-Paste-Lösungen. Ergänze konkrete Werte, Quellenangaben und Begründungen.

Typische Fehler vermeiden

- Gütekriterien nur oberflächlich erwähnen: Viele Arbeiten schreiben einen Satz wie „Die Gütekriterien wurden beachtet“, ohne konkret zu werden. Das überzeugt nicht. Nenne stattdessen konkrete Maßnahmen und Werte.

- Reliabilität mit Validität verwechseln: Ein häufiger Fehler. Cronbachs Alpha zeigt Reliabilität, nicht Validität. Eine reliable Skala kann trotzdem das Falsche messen. Trenne die Konzepte sauber.

- Quantitative Kriterien auf qualitative Forschung anwenden: Qualitative Forschung hat eigene Gütekriterien. „Objektivität“ im engen Sinne passt nicht zu einem interpretativen Paradigma. Nutze stattdessen Transparenz, Reflexivität und Sättigung.

- Limitationen verschweigen: Es ist besser, offen zu benennen, welche Gütekriterien nicht umfassend geprüft werden konnten, als so zu tun, als gäbe es keine Einschränkungen. Das zeigt wissenschaftliche Reife.

- Intercoderreliabilität vergessen: Bei qualitativer Codierung solltest du mindestens einen Teil des Materials von einer zweiten Person codieren lassen oder begründen, warum das nicht möglich war.

Nächste Schritte

Wenn du die Gütekriterien für deine Arbeit durchdacht hast, kannst du diese Schritte angehen.

- Methodik planen: Überlege bei jedem Schritt deiner Erhebung und Auswertung, wie du Qualität sicherstellst. Standardisierte Durchführung, klare Auswertungsregeln, dokumentiertes Vorgehen sind der Schlüssel.

- Skalen prüfen: Wenn du etablierte Skalen nutzt, recherchiere deren Reliabilitätswerte in der Originalliteratur. Berechne nach deiner Erhebung Cronbachs Alpha für deine Stichprobe.

- Methodikteil schreiben: Plane einen eigenen Abschnitt für Gütekriterien im Methodenkapitel. Beschreibe konkret, was du getan hast und welche Werte du erreicht hast.

- Limitationen reflektieren: Im Diskussionsteil deiner Arbeit greifst du die Gütekriterien noch einmal auf. Hier benennst du Einschränkungen und ordnest ein, wie sie die Aussagekraft deiner Ergebnisse beeinflussen.

Wenn du deine Masterarbeit drucken und binden lassen möchtest, kannst du das bei BachelorHero online konfigurieren.

Häufig gestellte Fragen

Was sind die drei klassischen Gütekriterien?

Die drei klassischen Gütekriterien quantitativer Forschung sind Objektivität (Unabhängigkeit vom Forschenden), Reliabilität (Zuverlässigkeit und Wiederholbarkeit) und Validität (Gültigkeit der Messung). Sie hängen hierarchisch zusammen: Ohne Objektivität keine Reliabilität, ohne Reliabilität keine Validität.

Wie berichte ich Cronbachs Alpha korrekt im Ergebnisteil?

Berichte für jede Skala: Name, Itemanzahl, Cronbachs Alpha (α) und eine kurze Interpretation. Beispiel: „Die Skala Arbeitszufriedenheit (5 Items) wies eine interne Konsistenz von α = .82 auf, was als gut gilt (Nunnally, 1978).“ Bei Werten unter .70 begründe, warum du die Skala trotzdem verwendest (z. B. explorativer Charakter, wenige Items). Ergänzend kannst du McDonald’s Omega (ω) berichten, wenn dein Tool es bietet.

Was sind Nebengütekriterien und brauche ich die in jeder Masterarbeit?

Nebengütekriterien wie Ökonomie (vertretbarer Aufwand), Zumutbarkeit (für Teilnehmende), Fairness (keine Benachteiligung bestimmter Gruppen) und Nützlichkeit sind vor allem bei Testentwicklung relevant. In den meisten Masterarbeiten reicht es, die Hauptkriterien zu adressieren. Wenn du ein eigenes Instrument entwickelst oder vulnerable Gruppen befragst, solltest du Nebengütekriterien aber kurz reflektieren.

Muss ich Intercoderreliabilität machen – und was, wenn ich niemanden habe?

Intercoderreliabilität stärkt die Qualität qualitativer Auswertungen, ist aber nicht immer realistisch. Alternativen: (1) Mindestens 10–20 % des Materials von einer zweiten Person codieren lassen (z. B. Kommilitone). (2) Peer-Debriefing: Codierschema und Beispiele mit jemandem diskutieren. (3) Falls beides unmöglich: Im Methodikteil transparent begründen, dass du allein codiert hast, und beschreiben, wie du Konsistenz gesichert hast (z. B. zweimaliges Durchgehen des Materials).

Wie prüfe ich die Validität meiner Messung?

Validität wird auf mehreren Ebenen geprüft. Inhaltsvalidität: Expertenurteil, ob Items das Konstrukt abdecken. Konstruktvalidität: Faktorenanalyse, konvergente und diskriminante Validität. Kriteriumsvalidität: Korrelation mit externem Kriterium. In Masterarbeiten ist oft nicht alles prüfbar, dokumentiere dann, welche Aspekte du geprüft hast.

Gelten Gütekriterien auch für qualitative Forschung?

Für qualitative Forschung gelten alternative Gütekriterien: Transparenz (nachvollziehbares Vorgehen), Reflexivität (eigene Rolle reflektieren), theoretische Sättigung (genug Material erhoben). Manche Lehrstühle nutzen den Begriff „Trustworthiness“ (Glaubwürdigkeit, Übertragbarkeit, Zuverlässigkeit, Bestätigbarkeit). Prüfe, welche Terminologie dein Lehrstuhl erwartet.

Was ist der Unterschied zwischen interner und externer Validität?

Interne Validität fragt, ob die Ergebnisse innerhalb der Studie stimmen: Misst du wirklich den Effekt, den du messen willst? Externe Validität fragt, ob die Ergebnisse auf andere Kontexte übertragbar sind. Beide stehen oft in Spannung: Hohe Kontrolle (intern) kann die Generalisierbarkeit (extern) einschränken.

Wo beschreibe ich die Gütekriterien in der Masterarbeit?

Gütekriterien gehören in den Methodikteil (welche Maßnahmen du ergriffen hast) und in die Diskussion (welche Limitationen bleiben). Bei Skalen: Cronbachs Alpha im Ergebnisteil bei der Stichprobenbeschreibung berichten. Bei Interviews: Intercoderreliabilität oder Transparenz des Codierprozesses im Methodikteil dokumentieren, Sättigung begründen.

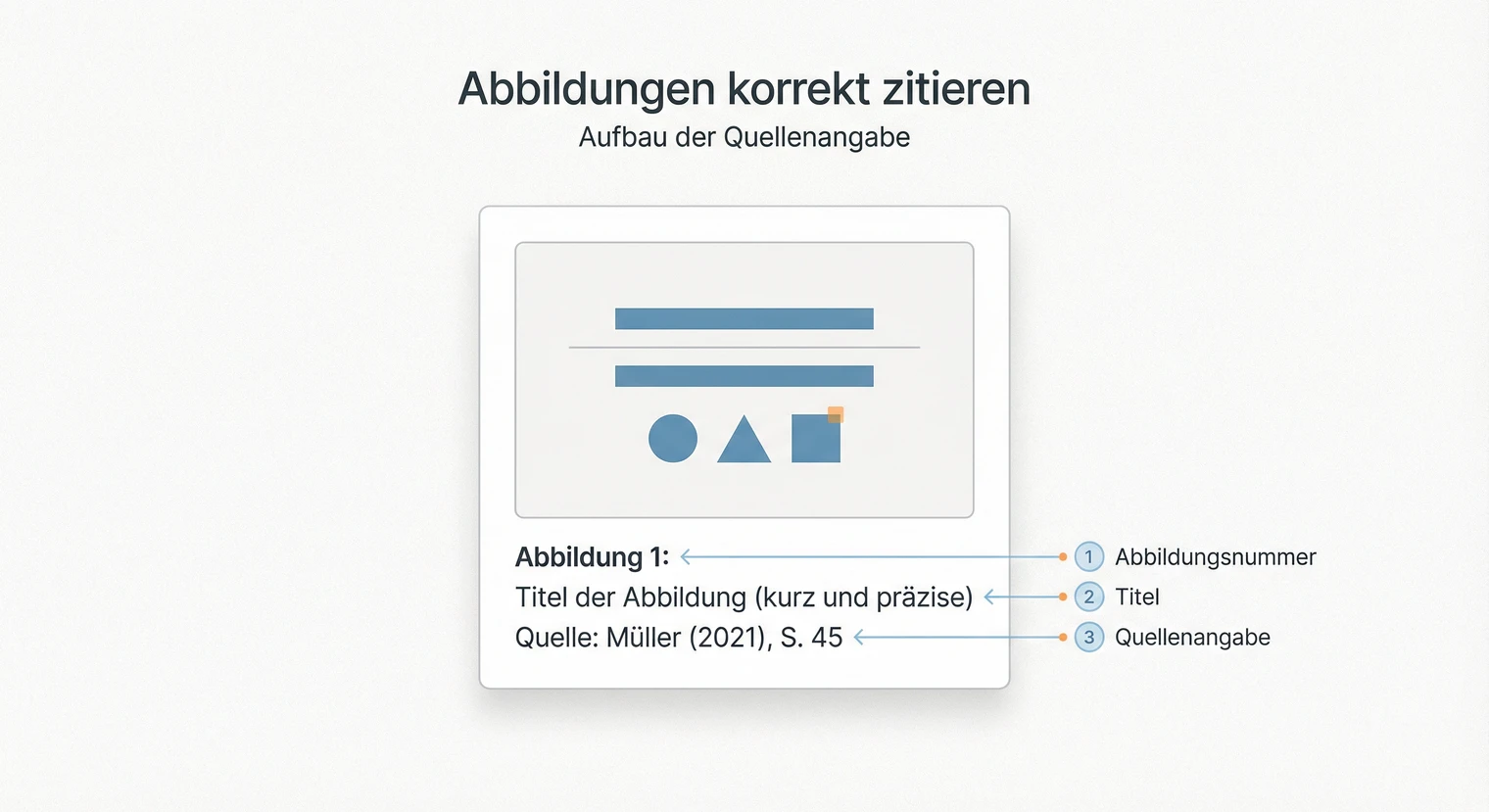

Bilder und Grafiken zitieren

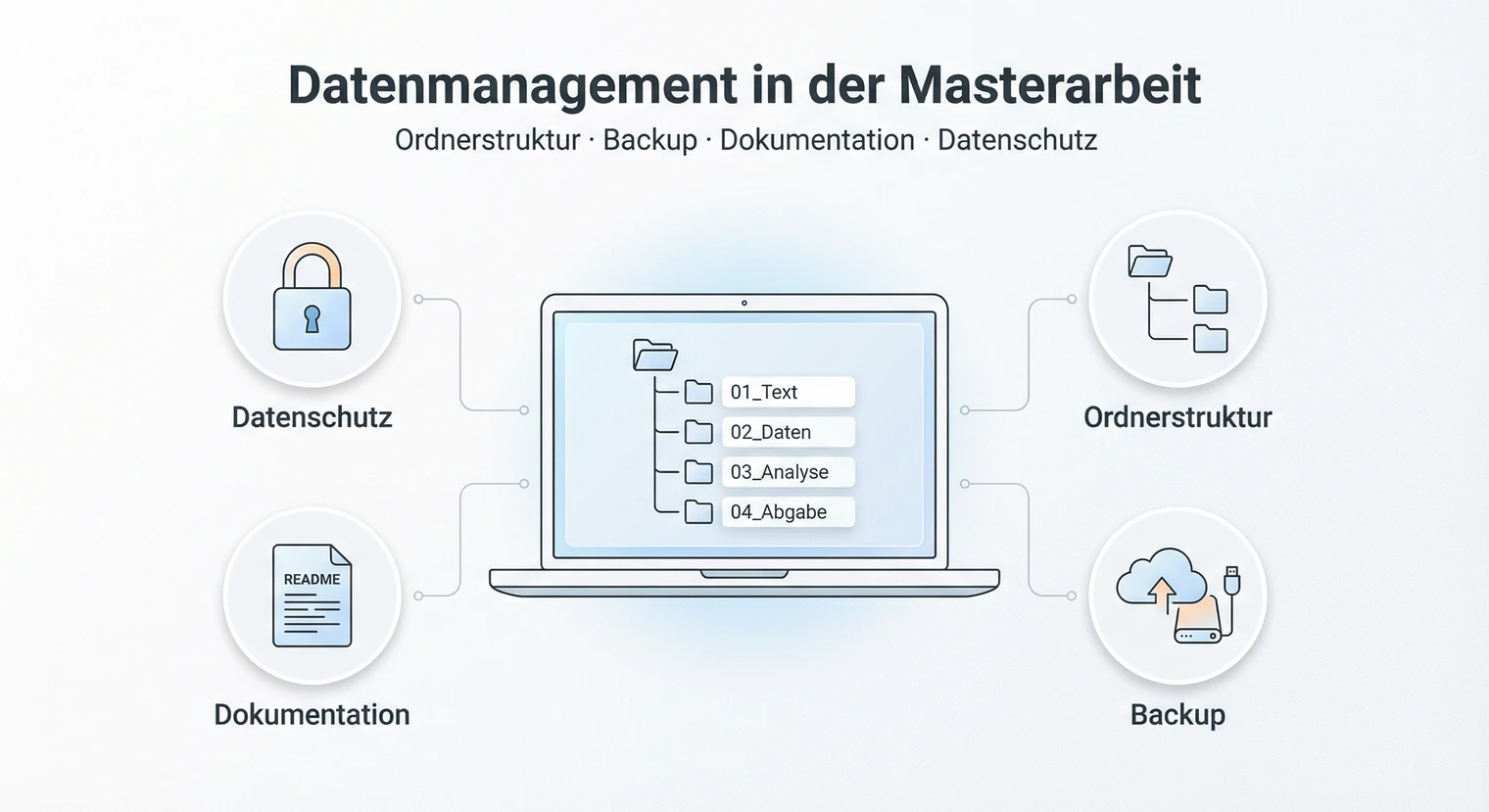

Bilder und Grafiken zitieren  Datenmanagement in der Masterarbeit

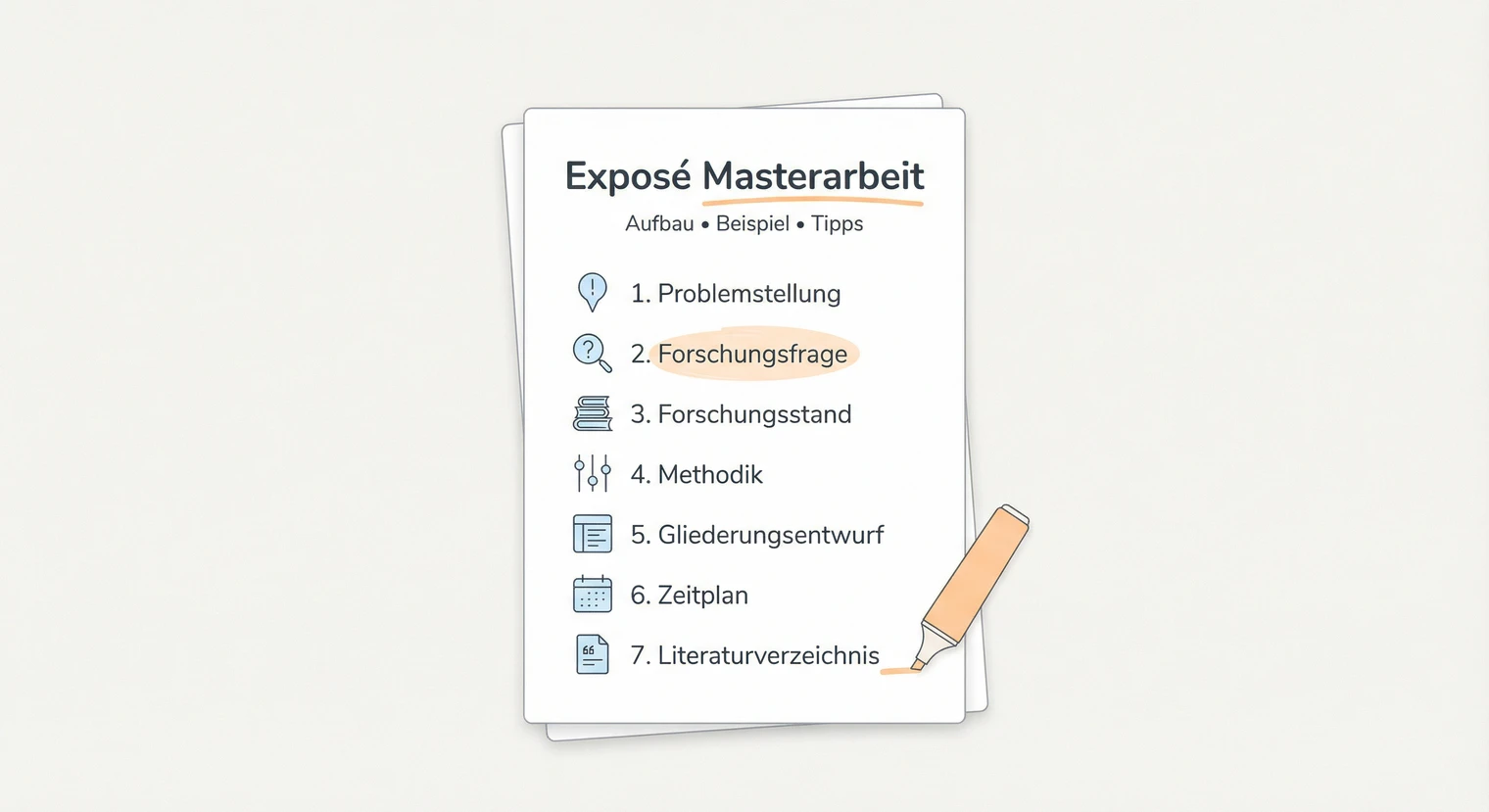

Datenmanagement in der Masterarbeit  Exposé für die Masterarbeit

Exposé für die Masterarbeit